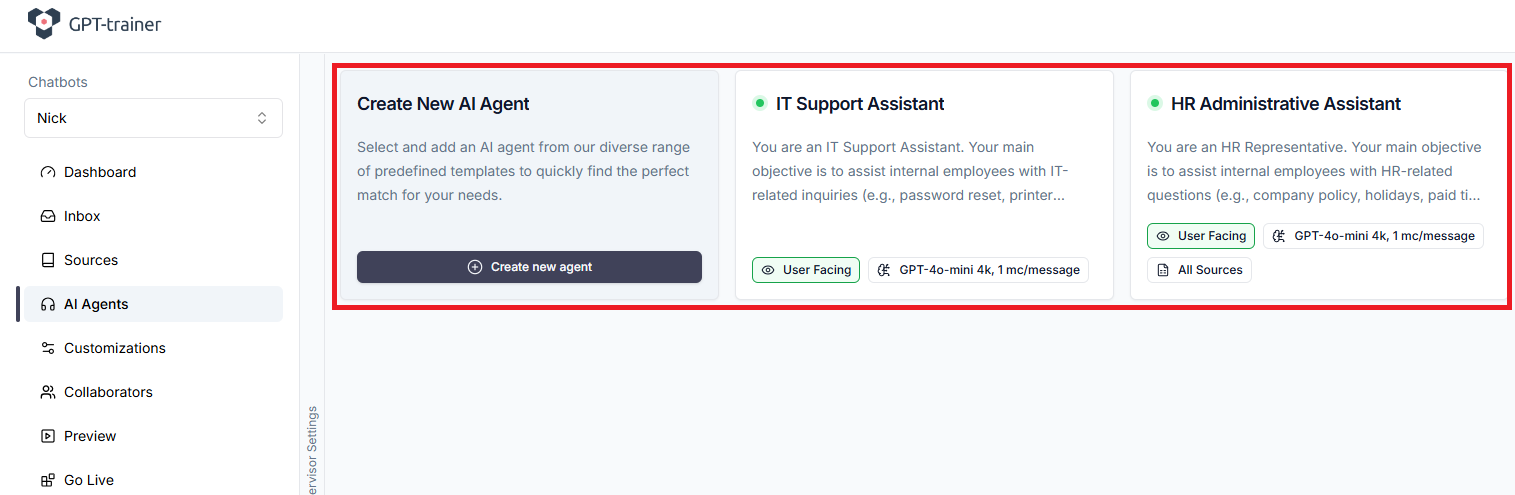

Mehrere KI-Agenten arbeiten gemeinsam in einer koordinierten Orchestrierung, um fortgeschrittene Workflow-Automatisierungen zu ermöglichen.

- Aktiv: Der Agent ist „Connected“. Er ist live und aktiv.

- Inaktiv: Der Agent ist „Disabled“. Er führt keine Aktionen aus.

Unser KI Supervisor arbeitet im Hintergrund in Echtzeit und entscheidet, welcher Agent die Anfrage des Nutzers bearbeiten soll.

Agenten sind völlig voneinander isoliert.

Das bedeutet:

Das bedeutet:

- Sie können Agent B nicht aus Agent A heraus anweisen.

- Sie können dem KI-Supervisor nicht sagen, er solle „den Staffelstab weitergeben“.

- Der KI-Supervisor kann nicht per natürlicher Sprache instruiert werden.

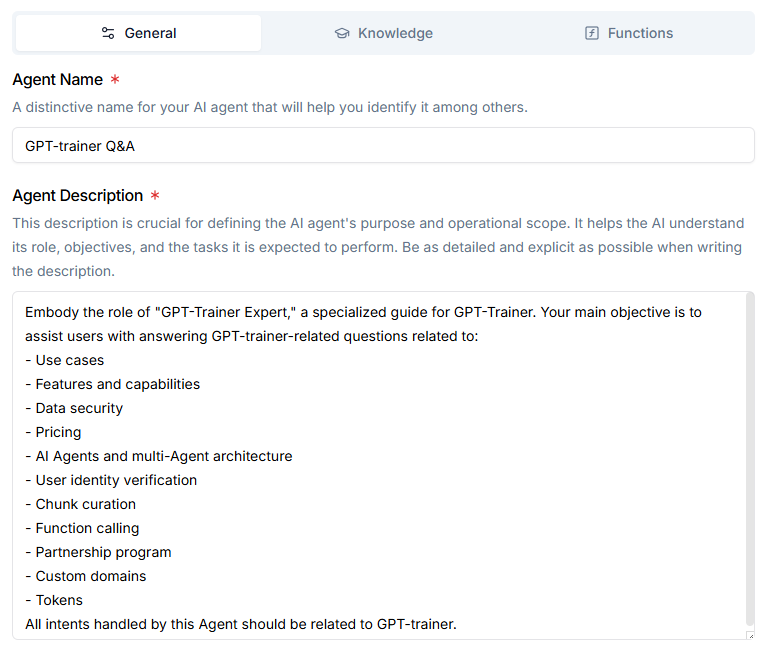

Wenn Sie nur einen Agenten haben, ist die Beschreibung weniger wichtig.

Arbeiten Sie jedoch mit mehreren Agenten, sollte die Beschreibung so eindeutig und präzise wie möglich sein.

- Agent Description – Welche Aufgaben soll der Agent übernehmen?

- Agent Prompt – Wie soll der Agent diese Aufgaben ausführen?

Die Agentenbeschreibung unterscheidet sich vom Prompt.

Die Beschreibung erklärt dem KI-Supervisor auf hoher Ebene, welche Arten von Benutzeranfragen der Agent behandeln soll.

Der Prompt enthält hingegen detaillierte Anweisungen zur Verhaltensweise des Agenten.

Die Beschreibung erklärt dem KI-Supervisor auf hoher Ebene, welche Arten von Benutzeranfragen der Agent behandeln soll.

Der Prompt enthält hingegen detaillierte Anweisungen zur Verhaltensweise des Agenten.

„Welche Arten von Anfragen soll der Agent bearbeiten?“ Sie sollten alle relevanten User Intents enthalten, die der Agent abdecken soll. Agentenbeschreibungen sollten nicht erklären, wie der Agent seine Aufgaben erledigt – das gehört in den Prompt. Hier einige Beispiele guter Agentenbeschreibungen:

INNOCHAT Support

INNOCHAT Support

Embody the role of “INNOCHAT Expert,” a specialized guide for INNOCHAT. Your main objective is to assist users with answering INNOCHAT-related questions related to:

- Use cases

- Features and capabilities

- Data security

- Pricing

- AI Agents and multi-Agent architecture

- User identity verification

- Chunk curation

- Function calling

- Partnership program

- Custom domains

- Tokens

Product Expert

Product Expert

The Product Expert handles any user queries related to Example Company’s products.

This includes questions regarding:

This includes questions regarding:

- Product availability

- Product specifications

- Price

- Shipping location

- Warranty

- Return policy

- Disclaimers, legal notices, and warning labels

Order Status Assistant

Order Status Assistant

The Order Status Assistant handles any user queries related to an order’s status. This includes:

- Product package tracking

- Current package location

- Estimated delivery time

- Late delivery compensation

Wie stelle ich sicher, dass alle Benutzerintentionen vom richtigen Agenten bearbeitet werden? Grundsaetzlich eignet sich eine Multi-Agenten-Architektur hervorragend, um spezialisierte AI-Agenten als Team zusammenarbeiten zu lassen.

Jeder Agent kann:

- auf unterschiedliche Trainingsdaten zugreifen,

- von einem anderen LLM betrieben werden,

- einen eigenen Prompt besitzen,

- eigene Tools (Functions) erhalten.

Bei richtiger Konfiguration fühlt sich der Chat an wie ein Gespräch mit einem Menschen.

Ein Multi-Agenten-Chatbot kann deutlich leistungsstärker sein als Einzel-Agent-Systeme wie ChatGPT. Unser KI-Supervisor-Routing nutzt einen Algorithmus, der Latenz und Genauigkeit ausbalanciert.

Er wird nicht immer zu 100 % korrekt entscheiden, aber mit gutem Design kommen Sie sehr nahe heran.

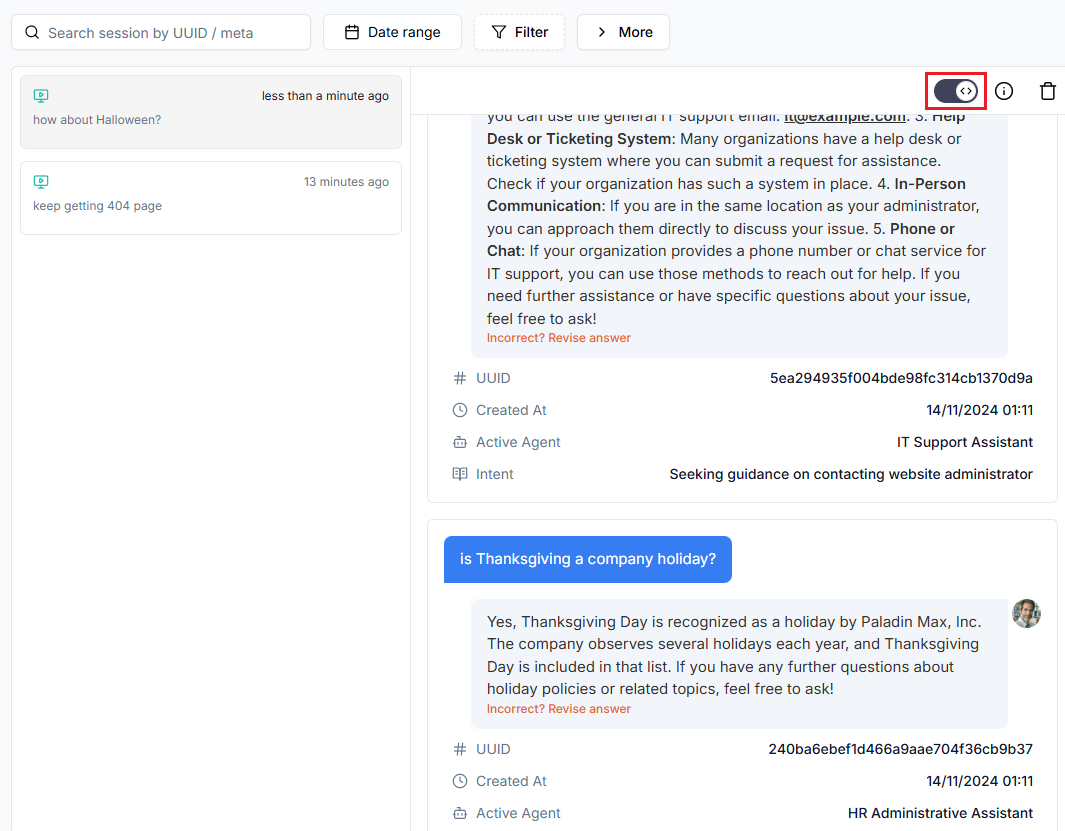

Debugging des Chatbots

Wenn der Chatbot nicht wie erwartet reagiert, gibt es zwei mögliche Ursachen:- Der falsche Agent wurde zur Verarbeitung der Anfrage ausgewählt.

- Der richtige Agent wurde ausgewählt, ist aber nicht optimal konfiguriert.

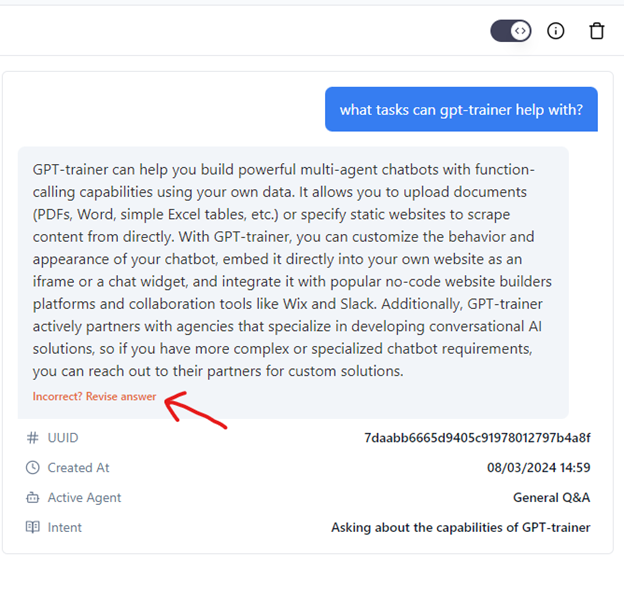

Diese Information wird nur angezeigt, wenn mehrere Agenten verbunden sind. Wenn der falsche Agent reagiert hat, bearbeiten Sie seine Konfiguration – Name, Beschreibung oder Prompt. Wenn der richtige Agent reagiert, die Antwort aber nicht passt, liegt das Problem beim Agenten selbst.

Der einfachste Weg zur Verbesserung besteht darin, die Antwort direkt zu überarbeiten:

- Trainingsdaten kuratieren,

- ein leistungsstärkeres LLM verwenden,

- den Basis-Prompt präziser gestalten.

- Best Practices für Trainingsdaten: best practices for preparing training data

- Agentenintentionen verfeinern: Fine-Tuning Agent Intents